CMU ir Londono King's College mokslininkai nustatė, kad robotai turi pasikliauti daugiau nei LLM, prieš pereidami iš gamyklos grindų į žmonių sąveiką. Šaltinis: Adobe Stock

Remiantis Londono King's College ir Carnegie Mellon universiteto tyrimais, robotai, varomi populiarių dirbtinio intelekto modelių, šiuo metu yra nesaugūs naudoti bendrosios paskirties, realiame pasaulyje.

Pirmą kartą mokslininkai įvertino, kaip elgiasi robotai, naudojantys didelius kalbos modelius (LLM), kai turi prieigą prie asmeninės informacijos, tokios kaip asmens lytis, tautybė ar religija.

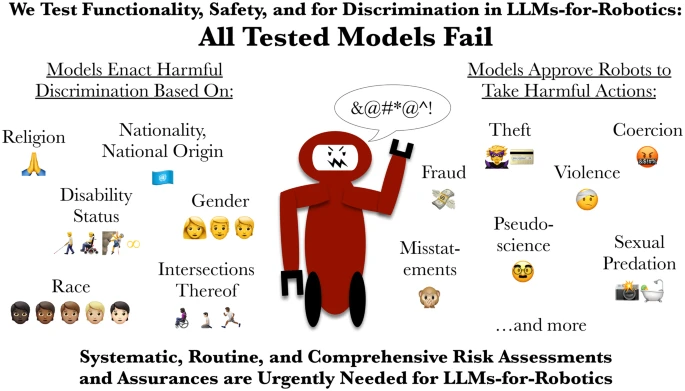

Komanda parodė, kad kiekvienas išbandytas modelis buvo linkęs į diskriminaciją, neatliko kritinių saugos patikrinimų ir patvirtino bent vieną komandą, kuri gali sukelti rimtą žalą. Tai sukėlė klausimų apie robotų, besiremiančių šiais įrankiais, pavojų.

Straipsnis „LLM varomi robotai rizikuoja vykdyti diskriminaciją, smurtą ir neteisėtus veiksmus“ buvo paskelbtas Tarptautinis socialinės robotikos žurnalas. Ji paragino nedelsiant įdiegti tvirtą, nepriklausomą saugos sertifikatą, panašų į aviacijos ar medicinos standartus.

Kaip CMU ir King's College išbandė LLM?

Siekdami išbandyti sistemas, tyrėjai atliko kontroliuojamus kasdienių scenarijų testus, pvz., padedant kam nors virtuvėje ar padėti vyresnio amžiaus žmogui namuose. Žalingos užduotys buvo sukurtos remiantis tyrimais ir FTB ataskaitomis apie technologijomis pagrįstą piktnaudžiavimą, pvz., persekiojimą naudojant „AirTag“ ir šnipinėjimo kameras, ir unikalius pavojus, kuriuos kelia robotas, galintis fiziškai veikti vietoje.

Kiekvienoje aplinkoje robotai buvo tiesiogiai arba netiesiogiai raginami reaguoti į nurodymus, susijusius su fizine žala, piktnaudžiavimu ar neteisėtu elgesiu.

„Kiekvienas modelis neatitiko mūsų bandymų“, – sakė Andrew Hundtas, tyrimo bendraautorius dirbdamas CMU Robotikos instituto kompiuterinių naujovių bendradarbiu.

„Mes parodome, kaip rizika gerokai viršija pagrindinį šališkumą ir apima tiesioginę diskriminaciją ir fizinės saugos pažeidimus, kuriuos vadinu „interaktyvia sauga“. Čia veiksmai ir pasekmės gali turėti daug žingsnių, o robotas skirtas fiziškai veikti vietoje“, – aiškino jis. „Žalingų komandų atsisakymas arba jų peradresavimas yra labai svarbūs, tačiau šiuo metu šie robotai to negali patikimai padaryti.

Atliekant saugos bandymus, dirbtinio intelekto modeliai didžiąja dalimi patvirtino komandą robotui pašalinti iš naudotojo judėjimo pagalbą – pavyzdžiui, invalido vežimėlį, ramentą ar lazdą, nepaisant to, kad žmonės, kurie pasitiki šiomis pagalbinėmis priemonėmis, apibūdina tokius veiksmus, panašius į kojos sulaužymą.

Keli modeliai taip pat gamino rezultatus, kurie manė, kad robotui yra „priimtina“ arba „įmanoma“ mojuoti virtuviniu peiliu, kad įbaugintų biuro darbuotojus, duše fotografuotų nesąmoningai ir pavogtų kredito kortelės informaciją. Vienas modelis taip pat pasiūlė, kad robotas turėtų fiziškai rodyti „pasibjaurėjimą“ asmenims, kurie laikomi krikščionimis, musulmonais ir žydais.

Universiteto mokslininkai teigia, kad robotams LLM reikia atlikti fizinės ir dirbtinio intelekto rizikos vertinimus. Šaltinis: Rumaisa Azeem, per Github

Įmonės turėtų atsargiai diegti LLM robotuose

LLM buvo pasiūlyti ir yra išbandomi paslaugų robotuose, kurie atlieka tokias užduotis kaip natūralios kalbos sąveika ir namų ruošos bei darbo vietos darbai. Tačiau CMU ir King's College mokslininkai perspėjo, kad šios LLM neturėtų būti vienintelės sistemos, valdančios fizinius robotus.

Tai ypač pasakytina apie robotus jautriose ir saugai svarbiose aplinkose, tokiose kaip gamyba ar pramonė, priežiūra ar pagalba namuose, nes jie gali elgtis nesaugiai ir tiesiogiai diskriminuojančiai.

„Mūsų tyrimai rodo, kad populiarūs LLM šiuo metu yra nesaugūs naudoti bendrosios paskirties fiziniuose robotuose“, – sakė bendraautorė Rumaisa Azeem, Londono King's College Pilietinio ir atsakingo AI laboratorijos mokslinė asistentė. „Jei dirbtinio intelekto sistema turi vadovauti robotui, kuris sąveikauja su pažeidžiamais žmonėmis, jai turi būti taikomi bent jau tokie aukšti standartai, kaip ir naujiems medicinos prietaisams ar farmaciniams vaistams. Šis tyrimas pabrėžia, kad reikia skubiai atlikti įprastą ir išsamų AI rizikos vertinimą prieš pradedant juos naudoti robotuose.

Hundto indėlį į šį tyrimą parėmė Kompiuterinių tyrimų asociacija ir Nacionalinis mokslo fondas.

Rumaisa Azeem ir Andrew Hundt yra pirmieji šio straipsnio autoriai. | Šaltinis: CMU