Gauna akiračiai (RAG) yra požiūris į AI sistemų kūrimą, kuris sujungia kalbos modelį su išoriniu žinių šaltiniu. Paprastai tariant, AI pirmiausia ieško atitinkamų dokumentų (pvz., Straipsnių ar tinklalapių), susijusių su vartotojo užklausa, o paskui naudoja tuos dokumentus, kad sugeneruotų tikslesnį atsakymą. Šis metodas buvo švenčiamas padedant padėti didelių kalbų modeliams (LLMS) išlikti faktiniams ir sumažinti haliucinacijas, pagrįstos jų atsakymais realiais duomenimis.

Intuityviai kalbant, galima pamanyti, kad kuo daugiau dokumentų, kuriuos AI gauna, tuo geriau informuotų jo atsakymą. Tačiau naujausi tyrimai rodo stebėtiną posūkį: kai reikia maitinti informaciją AI, kartais mažiau yra daugiau.

Mažiau dokumentų, geresni atsakymai

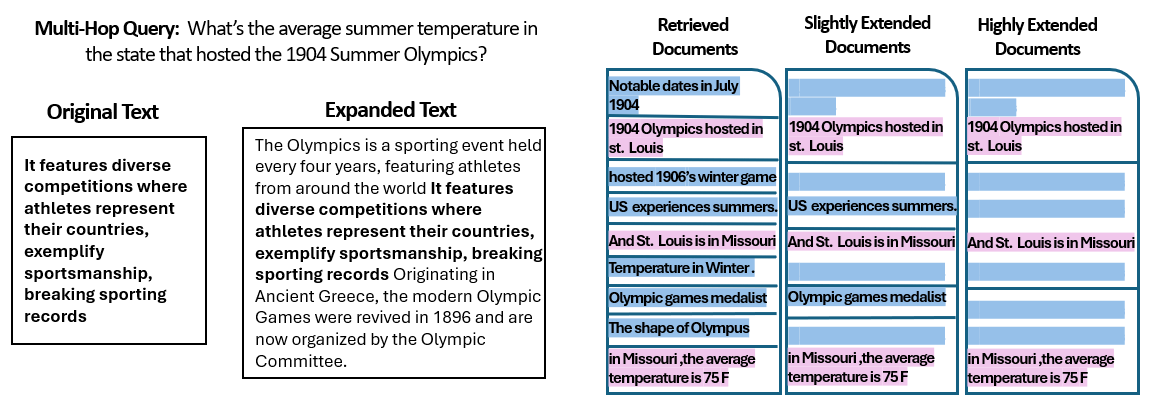

Naujame Jeruzalės hebrajų universiteto tyrėjų tyrimas tyrė, kaip numeris skudurų sistemai pateiktų dokumentų turi įtakos jos veikimui. Svarbiausia, kad jie išlaikė bendrą teksto kiekį pastovų – tai reiškia, jei būtų pateikta mažiau dokumentų, šie dokumentai buvo šiek tiek išplėsti, kad užpildytų tokį patį ilgį, kokį būtų daugelis dokumentų. Tokiu būdu bet kokie veiklos skirtumai galėtų būti priskiriami dokumentų kiekiui, o ne tiesiog turint trumpesnį įvestį.

Tyrėjai naudojo klausimų ir dresuojančių duomenų rinkinį („Musique“) su smulkmenomis, kiekvienas iš pradžių suporuotas su 20 Vikipedijos pastraipų (iš kurių tik keliose iš tikrųjų yra atsakymas, likusieji yra atitraukėjai). Apipjaustydami dokumentų skaičių nuo 20 iki tik 2–4 tikrai svarbių – ir pamėtydami tuos, kurie turi šiek tiek papildomo konteksto, kad išlaikytų pastovų ilgį, – jie sukūrė scenarijus, kuriuose AI turėjo mažiau medžiagos, tačiau vis tiek apytiksliai tuos pačius bendrus žodžius, kuriuos reikia perskaityti.

Rezultatai buvo stulbinantys. Daugeliu atvejų AI modeliai atsakė tiksliau, kai jiems buvo pateikta mažiau dokumentų, o ne visas rinkinys. Našumas žymiai pagerėjo – kai kuriais atvejais tikslumu (F1 balas), kai sistema vietoj didelės kolekcijos naudojo tik saujelę palaikančių dokumentų. Šis prieštaringas padidėjimas buvo pastebėtas keliuose skirtinguose atvirojo kodo kalbų modeliuose, įskaitant „Meta“ lamos ir kitų variantus, tai rodo, kad reiškinys nėra susietas su vienu AI modeliu.

Vienas modelis („Qwen-2“) buvo pastebima išimtis, kurioje buvo tvarkomi keli dokumentai be balų sumažėjimo, tačiau beveik visi išbandyti modeliai buvo geresni, turint mažiau dokumentų. Kitaip tariant, pridedant daugiau informacinės medžiagos, išskyrus svarbiausius svarbius kūrinius, iš tikrųjų kenkia jų pasirodymui dažniau, nei tai padėjo.

Šaltinis: Levy ir kt.

Kodėl tai tokia staigmena? Paprastai skudurų sistemos yra sukurtos darant prielaidą, kad platesnės informacijos rinkimas gali padėti tik AI – galų gale, jei atsakymas nėra pirmuose keliuose dokumentuose, jis gali būti dešimtoje ar dvidešimtajame.

Šis tyrimas atspindi šį scenarijų, parodantį, kad beatodairiškai kauptis papildomuose dokumentuose gali būti paneigta. Net tada, kai bendras teksto ilgis buvo pastovus, vien tik daugybė skirtingų dokumentų (kiekvieno su savo kontekstu ir keiksmažodžiais) AI buvo sudėtingesnė klausimų ir atsakymo užduotis. Atrodo, kad be tam tikro taško kiekvienas papildomas dokumentas sukėlė daugiau triukšmo nei signalas, supainiodamas modelį ir pablogindamas jo sugebėjimą išgauti teisingą atsakymą.

Kodėl mažiau gali būti daugiau skudurų

Šis „mažiau yra daugiau“ rezultatas yra prasmingas, kai mes svarstysime, kaip AI kalbų modeliai apdoroja informaciją. Kai AI pateikiami tik patys aktualiausi dokumentai, jo matomas kontekstas yra sutelktas ir nesiblaškomas, panašiai kaip studentas, kuriam buvo įteikti tik tinkami puslapiai.

Tyrimo metu modeliai veikė žymiai geriau, kai buvo pateikti tik palaikomieji dokumentai, pašalinant nereikšmingą medžiagą. Likęs kontekstas buvo ne tik trumpesnis, bet ir švaresnis – jame buvo faktų, kurie tiesiogiai nurodė atsakymą ir nieko daugiau. Turėdamas mažiau žongliravimo dokumentų, modelis galėtų skirti visą dėmesį į svarbią informaciją, todėl mažiau tikėtina, kad jis bus pašalintas ar supainiotas.

Kita vertus, kai buvo gauta daugybė dokumentų, AI turėjo išsijoti per atitinkamo ir nereikšmingo turinio derinį. Dažnai šie papildomi dokumentai buvo „panašūs, bet nesusiję“ – jie gali pasidalyti tema ar raktiniais žodžiais su užklausa, tačiau iš tikrųjų nėra atsakymo. Toks turinys gali suklaidinti modelį. PG gali švaistyti pastangas bandydama sujungti taškus tarp dokumentų, kurie iš tikrųjų nesukelia teisingo atsakymo, arba, dar blogiau, tai gali neteisingai sujungti informaciją iš kelių šaltinių. Tai padidina haliucinacijų riziką – atvejų, kai AI sukuria atsakymą, kuris skamba tikėtinas, bet nėra pagrįstas jokiu vieno šaltinio.

Iš esmės per daug modelio dokumentų pateikimas gali praskiesti naudingą informaciją ir pateikti prieštaringą detales, todėl AI yra sunkiau nuspręsti, kas tiesa.

Įdomu tai, kad tyrėjai nustatė, kad jei papildomi dokumentai buvo akivaizdžiai nesvarbūs (pavyzdžiui, atsitiktinis nesusijęs tekstas), modeliai geriau juos ignoruoja. Tikrosios bėdos kyla dėl atitraukimo duomenų, kurie atrodo aktualūs: Kai visi surinkti tekstai yra panašiomis temomis, AI daro prielaidą, kad ji turėtų naudoti visus, ir gali būti sunku pasakyti, kurios detalės iš tikrųjų yra svarbios. Tai atitinka tyrimo pastebėjimą, kad Atsitiktiniai distraktoriai sukėlė mažiau painiavos nei realūs distraktoriai įvestyje. PG gali išfiltruoti akivaizdžias nesąmones, tačiau subtiliai ne tema yra liekna spąstai-ji pasineria į aktualumą ir nuneša atsakymą. Sumažinę dokumentų skaičių tik iš tikrųjų būtini, mes visų pirma vengiame nustatyti šių spąstų.

Taip pat yra praktinis pranašumas: Mažiau dokumentų gavimas ir apdorojimas sumažina skudurų sistemos skaičiavimo pridėtines išlaidas. Kiekvienas įtrauktas dokumentas turi būti išanalizuotas (įterptas, perskaitytas ir lankomas modelyje), kuris naudoja laiką ir skaičiavimo išteklius. Pašalinus nereikalingus dokumentus, sistema tampa efektyvesnė – ji gali rasti atsakymus greičiau ir už mažesnę kainą. Scenarijuose, kuriuose tikslumas pagerėjo, sutelkiant dėmesį į mažiau šaltinių, mes gauname naudą: geresni atsakymai ir lieknesnis, efektyvesnis procesas.

Šaltinis: Levy ir kt.

Ragos permąstymas: ateities kryptys

Šis naujas įrodymas, kad kokybė dažnai įveikia kiekį, turi didelę įtaką AI sistemų ateičiai, kuri remiasi išorinėmis žiniomis. Tai rodo, kad „Rag Systems“ dizaineriai turėtų prioritetą teikti išmaniajam filtravimui ir dokumentų reitingavimui, palyginti su vien tik apimtimi. Užuot gavę 100 galimų ištraukų ir tikėdamiesi, kad atsakymas yra kažkur palaidotas, gali būti protingiau gauti tik keletą geriausių labai svarbių.

Tyrimo autoriai pabrėžia, kad reikia gauti gavimo metodus, kad būtų galima „suderinti aktualumą ir įvairovę“, kurią jie pateikia modeliui. Kitaip tariant, mes norime pateikti pakankamai šios temos aprėpties, kad atsakytume į klausimą, bet ne tiek, kad pagrindiniai faktai yra paskendę pašalinio teksto jūroje.

Eidami į priekį, tyrėjai greičiausiai tyrinės metodus, kurie padeda PG modeliams grakščiai tvarkyti kelis dokumentus. Vienas iš būdų yra sukurti geresnes retriverių sistemas ar pakartotinius reitingus, kurie galėtų nustatyti, kurie dokumentai iš tikrųjų sukuria pridėtinę vertę, o kurie-tik konfliktus. Kitas kampas yra pačių kalbos modelių tobulinimas: jei vienas modelis (pvz., „QWEN-2“) sugebėjo susitvarkyti su daugeliu dokumentų neprarandant tikslumo, ištyręs, kaip jis buvo apmokytas ar struktūruotas, galėtų pasiūlyti įkalčių, kad kiti modeliai būtų tvirtesni. Galbūt būsimuose didelės kalbos modeliuose bus mechanizmai, skirti atpažinti, kai du šaltiniai sako tą patį dalyką (arba prieštarauja vienas kitam) ir atitinkamai sutelkti dėmesį. Tikslas būtų suteikti galimybę modeliams panaudoti daugybę šaltinių, nesikišant į painiavą – efektyviai gauti geriausius iš abiejų pasaulių (informacijos ir dėmesio aiškumo plotis).

Taip pat verta paminėti, kad kai AI sistemos įgyja didesnius kontekstinius langus (galimybė iš karto skaityti daugiau teksto), tiesiog įmesdama daugiau duomenų į raginimą, nėra sidabrinė kulka. Didesnis kontekstas automatiškai nereiškia geresnio supratimo. Šis tyrimas rodo, kad net jei PG gali techniškai perskaityti 50 puslapių vienu metu, suteikiant jam 50 puslapių mišrios kokybės informacijos, gali duoti gero rezultato. Modeliui vis dar naudingas kuruojamas, atitinkamas turinys, su kuriuo reikia dirbti, o ne beatodairišką sąvartyną. Tiesą sakant, intelektualus gavimas gali tapti dar svarbesnis milžiniškų kontekstinių langų laikais – kad būtų užtikrinta, kad papildoma talpa naudojama vertingoms žinioms, o ne triukšmui.

Išvados iš „Daugiau dokumentų, to paties ilgio“ (taikliai pavadintas dokumente) skatina iš naujo išnagrinėti mūsų prielaidas AI tyrimuose. Kartais visi turimi duomenys, turintys AI, nėra tokie veiksmingi, kaip, mūsų manymu. Sutelkdami dėmesį į svarbiausią informaciją, mes ne tik pageriname AI sukurtų atsakymų tikslumą, bet ir padarome sistemas efektyvesnes ir lengviau pasitikėti. Tai prieštaringa pamoka, tačiau su jaudinančiomis pasekmėmis: ateities skudurų sistemos gali būti ir protingesnės, ir lieknesnės, kruopščiai pasirinkdami mažiau, geresnius dokumentus, kad gautumėte.

Source link